robots.txt ist eine Datei, die auf dem Wurzelverzeichnis deiner Website gespeichert wird und Suchmaschinen wie Google, Bing oder Yahoo sagt, welche Teile deiner Website gecrawlt werden dürfen und welche nicht. Mit anderen Worten: Es ist eine Art Wegweiser für Suchmaschinen, um herauszufinden, welche Seiten und Inhalte sie indexieren können und welche nicht.

Die robots.txt-Datei enthält Anweisungen für die sogenannten “Robots” (auch Crawler genannt) der Suchmaschinen, die den Inhalt deiner Website durchsuchen und analysieren. Die Anweisungen in der Datei geben an, welche Seiten von den Suchmaschinen gecrawlt werden dürfen und welche nicht. Wenn Suchmaschinen auf eine Seite oder einen Ordner deiner Website stoßen, die von der robots.txt-Datei ausgeschlossen sind, werden sie diese nicht indexieren und in den Suchergebnissen nicht anzeigen.

Grundlegende Struktur: Die robots.txt Datei besteht aus Gruppen von Anweisungen. Jede Gruppe besteht aus mindestens einem User-agent-Eintrag, gefolgt von mehreren Disallow– oder Allow-Einträgen.

User-agent: Dieser Eintrag gibt an, für welchen Web-Crawler die nachfolgenden Anweisungen gelten. Der Wert * steht für alle Crawler. Spezifische Crawler können mit ihrem Namen angegeben werden, z.B. Googlebot für den Google Web-Crawler.

Disallow: Mit diesem Eintrag können Sie Crawlern den Zugriff auf bestimmte Teile Ihrer Website verbieten. Wenn Sie z.B. nicht möchten, dass ein Crawler auf Ihr Verzeichnis /verboten/ zugreift, würden Sie Disallow: /verboten/ verwenden.

Allow: Obwohl dies nicht im ursprünglichen Protokoll enthalten war, verwenden viele moderne Crawler den Allow-Eintrag, um den Zugriff auf bestimmte Teile einer ansonsten gesperrten Ressource zu erlauben.

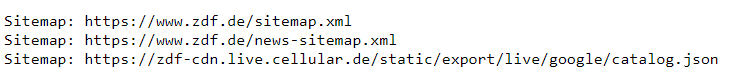

Sitemap: In der robots.txt Datei können Sie auch auf die Sitemap Ihrer Website verweisen, damit Crawler wissen, wo sie die Sitemap finden können. Dies geschieht mit dem Eintrag Sitemap:, gefolgt von der URL zur Sitemap.

Kommentare: Sie können Kommentare in Ihrer robots.txt Datei hinzufügen, indem Sie eine Zeile mit einem # beginnen. Crawler ignorieren solche Zeilen.

Beachtung der Anweisungen: Es ist wichtig zu wissen, dass die robots.txt Datei eine “Freundliche Bitte” und keine erzwungene Regel ist. Einige böswillige Crawler könnten die Anweisungen in der robots.txt Datei ignorieren.

Effektivität: Während die robots.txt Datei verhindern kann, dass Crawler bestimmte Seiten besuchen, verhindert sie nicht, dass diese Seiten über andere Quellen (z.B. externe Links) in Suchmaschinenindizes erscheinen.

Case-Sensitivity: Das Protokoll für robots.txt ist case-sensitive. Dies bedeutet, dass /Verboten/ und /verboten/ als unterschiedliche Pfade behandelt werden.

Testen: Es ist eine gute Praxis, Ihre robots.txt Datei in den Webmaster-Tools von Suchmaschinen (z.B. Google Search Console) zu testen, um sicherzustellen, dass sie korrekt funktioniert.

Die robots.txt Datei sollte im Hauptverzeichnis einer Website platziert werden, also beispielsweise unter https://beispiel.de/robots.txt.

Über den Browser gibst du die entsprechende URL ein: https://deineURL.de/robots.txt

User-agent: *

Disallow: /privat/

Disallow: /geheim/

In diesem Beispiel würde jedem Roboter (angegeben durch den User-agent: *) der Zugriff auf die Verzeichnisse /privat/ und /geheim/ verwehrt.

Hier die Robots.txt vom ZDF Online-Auftritt.

Ja, es können mehrere User-agent Einträge in einer robots.txt Datei existieren, um spezifische Anweisungen für verschiedene Crawler bereitzustellen.

Nein, die robots.txt Datei ist nicht verpflichtend. Wenn sie jedoch fehlt, könnten einige Crawler alle Inhalte der Website durchsuchen.

Obwohl die robots.txt Datei Crawlern mitteilt, welche Seiten nicht gecrawlt werden sollen, garantiert sie nicht, dass diese Seiten nicht in den Suchergebnissen erscheinen. Es ist besser, andere Methoden wie Meta-Tags oder HTTP-Header zu verwenden, um Inhalte aus Suchmaschinen zu entfernen.

Fehler in der robots.txt Datei können dazu führen, dass Suchmaschinenroboter wichtige Seiten nicht crawlen oder unerwünschte Seiten crawlen. Es ist daher wichtig, die Datei sorgfältig zu überprüfen.

Die Verwendung von robots.txt kann sich auf die Suchmaschinenoptimierung (SEO) auswirken, da sie dazu beitragen kann, dass Suchmaschinen nur relevante Seiten crawlen und indexieren. Dadurch wird vermieden, dass Suchmaschinen Ressourcen für das Crawling und die Indexierung von nicht relevanten Seiten verschwenden und die Suchergebnisse für die Nutzer relevanter und genauer werden.